WAN 2.6 简介(预览版)

阿里巴巴的 广域网 模型很快成为最受关注的模特之一 AI 视频生成器。WAN 2.1 因其逼真的视觉效果和强大的基准测试性能而备受关注,而 WAN 2.5 引入了一项重大飞跃:10 秒、1080p、24 fps 的视频 原生视听同步,由新的多模式引擎驱动,该引擎接受文本、图像、视频和音频作为输入。

在撰写本文时, WAN 2.6 阿里巴巴尚未正式发布。但是,根据中概述的明确方向 WAN 2.5 公告——更长的片段、同步的声音和更强的摄像机控制——可以合理地预计 WAN 2.6 将进一步发展 电影 AI 视频创作。

在本次预览中,我们将看看创作者可能能从中得到什么 WAN 2.6 AI 视频: 可能的关键功能,它将如何改善日常工作流程,以及下一代的用例类型 文字和图像到视频的人工智能 可以大放异彩。

创作者可以从 WAN 2.6 中得到什么(预测)

注意:以下功能是推测性的,基于 WAN 2.5 的官方功能和现代 AI 视频模型中的典型升级模式。

1。更长、更连贯的 AI 视频片段

WAN 2.5 已经将视频长度从 5 秒增加到 10 秒,同时保持了 1080p、24 帧/秒的画质。

可以合理地期待 WAN 2.6 通过以下方式延续这一趋势:

- 将最大片段长度延长到今天的 10 秒限制之后

- 提高整个序列的叙事连贯性

- 减少长镜头中的闪烁或掉帧等时间伪影

对于创作者来说,这意味着在单个单曲中为多节拍动作、迷你叙事或产品序列留出更多空间 AI 视频模型 跑。

2。更智能的文字到视频理解

WAN 2.5 已经支持 “电影级视觉控制” 和直接通过提示使用专业摄像机语言(灯光、色彩、构图和镜头类型)。

WAN 2.6 文字转视频 可能会加深这种情况:

- 更好地理解复杂的多句提示音

- 更准确地执行特定的摄像机动作(追踪镜头、缩放、POV)

- 提示音中的情感语气与最终场景之间的协调性更强

这会让 WAN 2.6 AI 视频 更适合结构化叙事和脚本驱动的内容,而不仅仅是简短的视觉实验。

3.更强的图像到视频的身份和动感

官方的 WAN 2.5 注释强调了将图像转换为视频时更稳定的动态效果以及更好地保留现有特征(风格、面孔、产品和文本)。

在此基础上, WAN 2.6 图像转视频 很可能:

- 即使动作更具戏剧性,也能保持角色身份的一致性

- 以较少的失真处理复杂的动作(转弯、跳跃、镜头快速移动)

- 在动画期间更可靠地维护徽标、用户界面元素和精细细节

这对于将产品渲染、角色概念或用户界面模型转换为流畅的动画序列而无需进行最少的清理工作特别有用。

4。更具表现力的音频和语音驱动的视频

WAN 2.5 是该系列中第一个提供的 音视频同步视频生成,生成与屏幕内容和唇部动作相匹配的人声、音效和背景音乐。

WAN 2.6 因此,很可能:

- 优化口型同步以获得更自然的语音和情感细微差别

添加更丰富的环境音景和更多样化的 SFX 库 - 改进 “音频驱动” 的工作流程,其中语音轨道可以驱动视频中的动作和表情

对于依赖的创作者 带音频的 AI 视频,这可能意味着直接来自模特的片段更接近最后的片段,减少了对单独配音或音乐制作的需求。

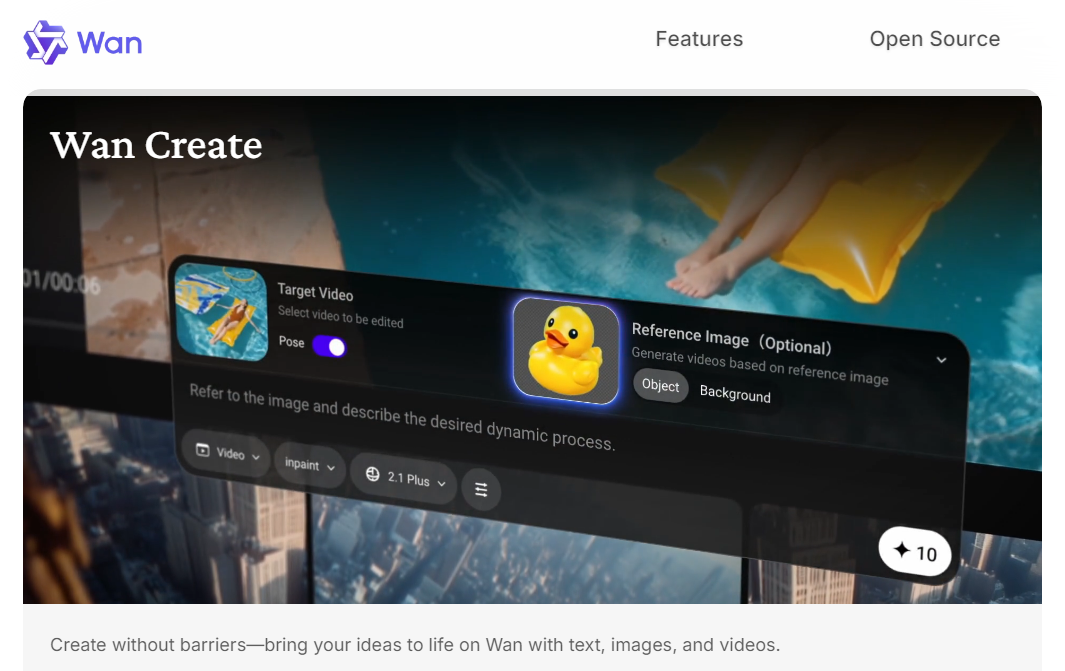

5。更严格的多模式控制和编辑工作流程

WAN 2.5 的原生多模式架构已经支持将文本、图像、视频和音频作为输入和输出。

下一步是 WAN 2.6 可能包括:

- 更灵活的文本 + 图像 + 音频提示组合

- 基本的编辑样式功能,例如扩展现有镜头、添加新动作或根据参考调整样式

- 在多张镜头中更容易重复使用角色或资产,实现简单的多镜头序列

如果这些预测成立,WAN 2.6 可能感觉不像 “单发生成器”,而更像紧凑型 AI 视频创作 用于简短、连贯序列的系统。

WAN 2.6 AI 视频的用例

同样,这些用例是推测性的,但它们自然会遵循广域网当前的方向和方向 WAN 2.5 发布已经成为可能。

1。带有原生音频的社交优先短视频

有了更长的片段和更好的视听同步, WAN 2.6 可能非常适合:

- TikTok/Reels/Shorts 带有对话或画外音的短片内容

- 带有集成声音设计的产品预告片

- 由音轨驱动的反应式或评论式片段

创作者可以描述场景和语气,附上简短的音频样本,然后让 WAN 2.6 AI 视频生成器 一次即可处理视觉和声音。

2。语音驱动的表演和会说话的内容

WAN 2.6 预计将成为下一个主要内容 AI 视频模型 来自阿里巴巴,基于 WAN 2.5 的 1080p 构建,音频同步 文字转视频 AI 提供更智能的故事讲述、更长的片段和更稳定的图像到视频生成。探索 WAN 2.6 的预期功能、用例,以及创作者对即将推出的产品有何期待 AI 视频生成器.2.5 已经支持 “语音转视频”,即单个图像加上音频可以生成具有详细面部和身体动作的表演视频。

WAN 2.6 可能会将其扩展到:

- 会说话的人讲解员和教育短片

- 虚拟主持人或主持人视频

- 角色表演(卡通或写实)与录制的对话同步

这将为教育工作者、网红和品牌提供一种无需设置实物拍摄即可快速制作镜头风格内容的方法。

3.概念、产品和场景动画

更稳定 图像到视频 而且持续时间更长,WAN 2.6 可能会在以下方面表现强劲:

- 将产品图片转换为简单的演示视频

- 通过摄像机动作将环境或关键艺术概念变为现实

- 为着陆页面、广告素材和活动制作简短的 “英雄镜头”

这些 AI 视频创作 工作流程有助于取代或增强经典 3D 或实景拍摄,以实现更简单的场景。

4。预览和故事探索

如果 WAN 2.6 继续改善摄像机控制和叙事连贯性,它可能有用于:

- 可视化剧本创意或故事板

- 在全面生产之前测试不同的视觉方向

- 快速制作广告序列或简短叙事曲线的原型

对于创作者和团队来说,情况发生了变化 WAN 2.6 视频型号 进入低摩擦力的沙箱中,尝试节奏、构图和心情。

结论

而 WAN 2.6 尚未正式发布,目前预计将于12月推出,延续阿里巴巴向更强大的多模式迈进 AI 视频生成 以及更聪明的讲故事。对于创作者来说,这可能意味着更长、更连贯的片段、更好的视听同步和更强大的功能 AI 视频模型 用于真实的制作工作流程。

Akool 会尽快将 WAN 2.6 集成到其 AI 视频套件中,这样您就可以抓住第一个机会尝试新的 WAN 2.6 人工智能视频功能。

敬请关注,期待在 Akool 上使用 WAN 2.6 创作下一波智能电影级内容。