Introducción a WAN 2.6 (versión preliminar)

De Alibaba WAN los modelos se han convertido rápidamente en algunos de los más comentados Generadores de vídeo con IA. WAN 2.1 llamó la atención por sus imágenes realistas y su sólido rendimiento de referencia, mientras que WAN 2.5 supuso un gran salto: vídeos de 10 segundos, 1080p y 24 fps con sincronización audiovisual nativa, impulsado por un nuevo motor multimodal que acepta texto, imágenes, vídeo y audio como entradas.

En el momento de redactar este informe, WAN 2.6 Alibaba aún no lo ha lanzado oficialmente. Sin embargo, según la clara dirección descrita en el WAN 2.5 anuncio (clips más largos, sonido sincronizado y un mayor control de la cámara), es razonable esperar que WAN 2.6 avance aún más hacia creación de vídeos cinematográficos con IA.

En esta vista previa, veremos lo que los creadores pueden esperar de Vídeo sobre WAN 2.6 AI: las posibles funciones clave, cómo podría mejorar los flujos de trabajo diarios y los tipos de casos de uso en los que se basa esta próxima generación IA de texto e imagen a vídeo podría brillar.

Qué pueden esperar los creadores de WAN 2.6 (previsto)

Nota: Las siguientes funciones son especulativas y se basan en las capacidades oficiales de WAN 2.5 y en los patrones de actualización típicos de los modelos de vídeo de IA modernos.

1. Videoclips de IA más largos y coherentes

La WAN 2.5 ya duplicó la duración del vídeo de 5 segundos a 10 segundos, manteniendo una calidad de 1080p y 24 fps.

Es razonable esperar WAN 2.6 para continuar con esta tendencia mediante:

- Ampliar la duración máxima de los clips más allá del límite actual de 10 segundos

- Mejorar la coherencia narrativa a lo largo de toda la secuencia

- Reducir los artefactos temporales, como el parpadeo o la caída de fotogramas en tomas más largas

Para los creadores, esto implicaría más espacio para acciones de varios tiempos, mininarrativas o secuencias de productos en un solo paso. Modelo de vídeo AI correr.

2. Comprensión más inteligente de texto a vídeo

La WAN 2.5 ya admite el «control visual a nivel de película» y el lenguaje de cámara profesional (iluminación, color, composición y tipo de toma) directamente desde las instrucciones.

Conversión de texto a vídeo de WAN 2.6 probablemente profundizará esto:

- Mejor comprensión de las instrucciones complejas y con múltiples cláusulas

- Ejecución más precisa de movimientos de cámara específicos (seguimiento de tomas, acercamientos, POV)

- Mayor alineación entre el tono emocional del mensaje y la escena resultante

Esto haría Vídeo sobre WAN 2.6 AI más adecuado para narraciones estructuradas y contenido basado en guiones, no solo para experimentos visuales breves.

3. Una identidad y un movimiento más sólidos entre imagen y vídeo

El funcionario WAN 2.5 las notas destacan una dinámica más estable y una mejor conservación de las características existentes (estilo, rostros, productos y texto) al convertir imágenes en vídeos.

Partiendo de esa base, WAN 2.6 de imagen a vídeo es probable que:

- Mantén la coherencia de la identidad del personaje incluso con movimientos más dramáticos

- Maneje movimientos complejos (giros, saltos, movimiento rápido de la cámara) con menos distorsión

- Mantenga los logotipos, los elementos de la interfaz de usuario y los detalles más precisos de forma más fiable durante la animación

Esto sería particularmente útil para convertir renderizados de productos, conceptos de personajes o maquetas de interfaz de usuario en secuencias animadas fluidas con una limpieza mínima.

4. Audio más expresivo y vídeo basado en la voz

WAN 2.5 es la primera de la serie que ofrece generación de vídeo sincronizado audiovisual, que produce voces humanas, efectos de sonido y música de fondo que coinciden con el contenido de la pantalla y los movimientos de los labios.

WAN 2.6 por lo tanto, es probable que:

- Perfecciona la sincronización de labios para lograr un discurso y un matiz emocional más naturales

Añade paisajes sonoros ambientales más ricos y bibliotecas de efectos especiales más variadas - Mejore los flujos de trabajo «basados en el audio», en los que una pista de voz puede impulsar tanto el movimiento como la expresión en el vídeo

Para creadores que confían en Vídeo de IA con audio, lo que podría significar clips más cercanos al final sacados directamente del modelo, con menos necesidad de voces en off o producciones musicales independientes.

5. Flujos de trabajo de edición y control multimodales más estrictos

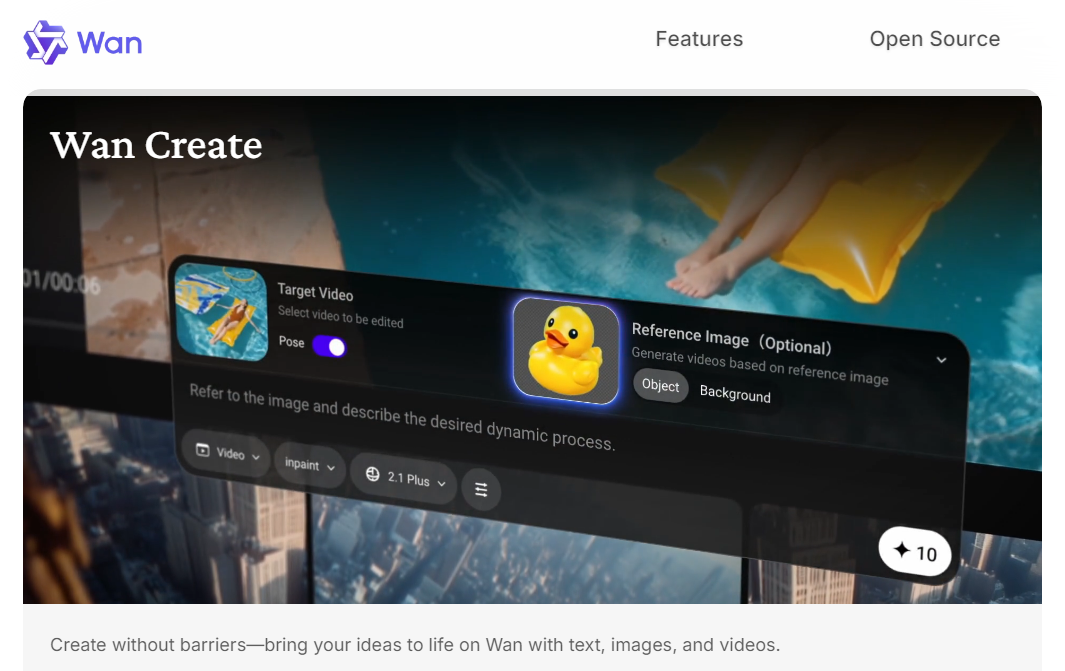

La arquitectura multimodal nativa de WAN 2.5 ya admite texto, imagen, vídeo y audio como entradas y salidas.

El siguiente paso para WAN 2.6 puede incluir:

- Combinaciones más flexibles de texto, imagen e instrucciones de audio

- Funciones básicas de estilo de edición, como extender una toma existente, añadir un movimiento nuevo o ajustar el estilo en función de una referencia

- Reutilización más sencilla de personajes o recursos en varias tomas para obtener secuencias sencillas de varias tomas

Si estas predicciones se mantienen, la WAN 2.6 podría parecerse menos a un «generador de un solo disparo» y más a una compacta Creación de vídeos con IA sistema para secuencias cortas y coherentes.

Casos de uso de WAN 2.6 AI Video

Una vez más, estos casos de uso son especulativos, pero se derivan naturalmente de la dirección actual de la WAN y de lo que WAN 2.5 el lanzamiento ya lo ha hecho posible.

1. Vídeo breve centrado en las redes sociales con audio nativo

Con clips más largos y una mejor sincronización audiovisual, WAN 2.6 probablemente sea ideal para:

- Contenido de TikTok/Reels/Cortometrajes con diálogo o voz en off

- Avance de productos con diseño de sonido integrado

- Clips tipo reacción o comentario impulsados por una pista de voz

Los creadores podían describir la escena y el tono, adjuntar una breve muestra de audio y dejar que Generador de vídeo WAN 2.6 AI maneja tanto las imágenes como el sonido en una sola pasada.

2. Rendimiento basado en la voz y contenido para personas que hablan

Se espera que WAN 2.6 sea la próxima gran Modelo de vídeo AI de Alibaba, basado en 1080p de WAN 2.5, sincronizado con audio IA de texto a vídeo para ofrecer una narración más inteligente, clips más largos y una generación de imagen a vídeo más estable. Descubre las funciones previstas de la WAN 2.6, los casos de uso y lo que los creadores pueden esperar de esta próxima Generador de vídeo AI.2.5 ya es compatible con la conversión de voz a vídeo, en la que una sola imagen más el audio pueden producir un vídeo de actuación con movimientos faciales y corporales detallados.

WAN 2.6 es probable que extienda esto para:

- Videos educativos y explicativos para personas que hablan

- Vídeos de presentadores o presentadores virtuales

- Interpretaciones de personajes (dibujos animados o realistas) sincronizadas con los diálogos grabados

Esto proporcionaría a los educadores, personas influyentes y marcas una forma rápida de producir contenido al estilo de la cámara sin tener que configurar una sesión física.

3. Animación de concepto, producto y escena

Con más estabilidad imagen a vídeo y duraciones más largas, WAN 2.6 probablemente sea adecuada para:

- Convertir imágenes de productos en sencillos vídeos de demostración

- Dar vida a conceptos ambientales o artísticos clave con el movimiento de la cámara

- Creación de «fotos de héroes» breves para páginas de destino, creatividades publicitarias y campañas

Estos Creación de vídeos con IA los flujos de trabajo ayudan a reemplazar o aumentar las tomas clásicas en 3D o de acción real para escenarios más sencillos.

4. Vista previa y exploración de la historia

Si la WAN 2.6 continúa mejorando el control de la cámara y la coherencia narrativa, podría resultar útil para:

- Visualización de ideas de guiones o guiones gráficos

- Probar diferentes direcciones visuales antes de la producción completa

- Creación rápida de prototipos de secuencias de anuncios o arcos narrativos cortos

Para los creadores y los equipos, esto se convierte Modelo de vídeo WAN 2.6 en una caja de arena de baja fricción para experimentar con el ritmo, el encuadre y el estado de ánimo.

Conclusión

Mientras WAN 2.6 aún no se ha lanzado oficialmente, actualmente se espera que se lance en diciembre, continuando con el impulso de Alibaba hacia una tecnología más potente y multimodal Generación de vídeo con IA y una narración más inteligente. Para los creadores, eso probablemente signifique clips más largos y coherentes, una mejor sincronización audiovisual y una mayor capacidad Modelo de vídeo AI para flujos de trabajo de producción reales.

Akool integrará WAN 2.6 en su suite de vídeo de IA tan pronto como esté disponible, para que pueda experimentar con las nuevas capacidades de vídeo de IA de WAN 2.6 a la primera oportunidad.

Mantente atento y espera crear tu próxima ola de contenido cinematográfico inteligente con WAN 2.6 en Akool.