WAN 2.6 소개 (미리 보기)

알리바바의 WAN 모델은 순식간에 가장 많은 화제가 되었습니다. AI 비디오 제너레이터.WAN 2.1은 사실적인 비주얼과 강력한 벤치마크 성능으로 주목을 받았지만 완 2.5 10초, 1080p, 24fps 비디오 등 획기적인 도약을 도입했습니다. 네이티브 오디오-비주얼 싱크텍스트, 이미지, 비디오 및 오디오를 입력으로 받아들이는 새로운 멀티모달 엔진에 의해 구동됩니다.

글을 쓰는 시점에서, 완 2.6 Alibaba에서 아직 공식적으로 출시하지 않았습니다.그러나 에 명시된 명확한 방향에 근거하여 완 2.5 발표: 더 긴 클립, 동기화된 사운드, 강력한 카메라 제어 기능 등 WAN 2.6이 한 단계 더 발전할 것으로 예상하는 것이 합리적입니다. 시네마틱 AI 비디오 제작.

이번 프리뷰에서는 크리에이터들이 무엇을 기대할 수 있는지 살펴보겠습니다. WAN 2.6 AI 비디오: 아마도 주요 기능, 일상적인 워크플로를 개선할 수 있는 방법, 이 차세대 제품의 사용 사례의 종류 텍스트 및 이미지-투-비디오 AI 빛날 수 있습니다.

제작자가 WAN 2.6에서 기대할 수 있는 것 (예상)

참고: 다음 기능은 WAN 2.5의 공식 기능과 최신 AI 비디오 모델의 일반적인 업그레이드 패턴을 기반으로 추측에 따른 것입니다.

1.더 길고 일관된 AI 비디오 클립

WAN 2.5는 이미 1080p, 24fps 화질을 유지하면서 비디오 길이를 5초에서 10초로 두 배로 늘렸습니다.

기대하는 것이 합리적입니다 완 2.6 다음과 같은 방법으로 이러한 추세를 이어가겠습니다.

- 최대 클립 길이를 현재의 10초 제한을 초과하여 확장

- 전체 시퀀스에서 내러티브 일관성 개선

- 장거리 촬영에서 깜박임 또는 프레임 드롭과 같은 일시적 아티팩트 감소

크리에이터 입장에서는 멀티비트 액션, 미니 내러티브 또는 제품 시퀀스를 한 공간에 더 많이 넣을 수 있다는 뜻입니다. AI 비디오 모델 를 실행합니다.

2.더욱 스마트해진 텍스트-비디오 이해

WAN 2.5는 이미 프롬프트에서 직접 “동영상 수준의 시각적 제어”와 전문 카메라 언어 (조명, 색상, 구도 및 샷 유형) 를 지원합니다.

WAN 2.6 텍스트-투-비디오 아마도 이것을 심화시킬 것입니다:

- 복잡한 다중 절 프롬프트에 대한 이해도 향상

- 특정 카메라 움직임 (트래킹 샷, 줌, POV) 을 보다 정확하게 실행

- 프롬프트의 감정적 어조와 결과 장면 간의 긴밀한 조화

이렇게 하면 WAN 2.6 AI 비디오 단순한 시각적 실험이 아닌 구조화된 스토리텔링과 스크립트 기반 콘텐츠에 더 적합합니다.

3.더욱 강력해진 이미지-투-비디오 아이덴티티 및 모션

더 오피셜 완 2.5 노트는 이미지를 비디오로 변환할 때 스타일, 얼굴, 제품 및 텍스트와 같은 기존 기능을 보다 안정적으로 유지하고 더 잘 보존되도록 강조합니다.

이를 바탕으로 WAN 2.6 이미지-투-비디오 다음과 같은 가능성이 있습니다.

- 극적인 모션에서도 캐릭터의 정체성을 일관되게 유지

- 왜곡을 줄이면서 복잡한 움직임 (회전, 점프, 빠른 카메라 움직임) 처리

- 애니메이션 중에 로고, UI 요소 및 세부 정보를 보다 안정적으로 유지

이는 제품 렌더링, 캐릭터 컨셉 또는 UI 목업을 최소한의 클린업으로 부드러운 애니메이션 시퀀스로 전환하는 데 특히 유용합니다.

4.표현력이 풍부한 오디오 및 음성 기반 비디오

WAN 2.5는 시리즈 최초의 제품입니다. 시청각 동기화 비디오 생성, 화면의 콘텐츠 및 입술 움직임에 맞는 사람의 목소리, 사운드 효과 및 배경 음악을 생성합니다.

완 2.6 따라서 다음과 같은 가능성이 있습니다.

- 립싱크를 개선하여 보다 자연스러운 말투와 감성적인 뉘앙스를 표현하세요

풍부한 앰비언트 사운드스케이프와 더 다양한 SFX 라이브러리 추가 - 음성 트랙이 비디오의 움직임과 표현을 모두 이끌어낼 수 있는 “오디오 기반” 워크플로우를 개선하세요.

에 의존하는 크리에이터를 위해 AI 비디오 (오디오 포함)즉, 별도의 보이스오버나 음악 제작이 필요 없이 모델에서 바로 최종 클립을 완성할 수 있다는 의미일 수 있습니다.

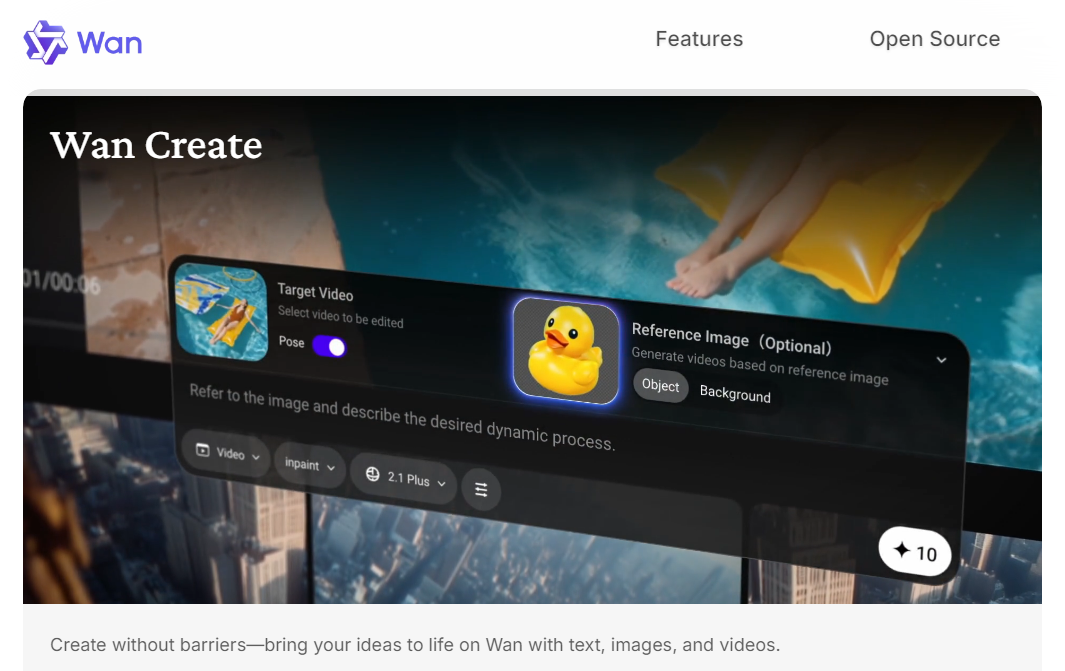

5.더욱 엄격해진 멀티모달 제어 및 편집 워크플로

WAN 2.5의 기본 멀티모드 아키텍처는 이미 텍스트, 이미지, 비디오 및 오디오를 입력과 출력으로 지원합니다.

다음 단계는 완 2.6 다음이 포함될 수 있습니다.

- 텍스트+이미지+오디오 프롬프트의 보다 유연한 조합

- 기본 편집 스타일 기능 (예: 기존 샷 확장, 새 모션 추가, 참조를 기반으로 스타일 조정)

- 간단한 멀티샷 시퀀스를 위해 여러 샷에서 캐릭터나 에셋을 더 쉽게 재사용할 수 있습니다.

이러한 예측이 사실이라면 WAN 2.6은 “싱글 샷 제너레이터”라기보다는 소형 제너레이터처럼 느껴질 수 있습니다. AI 비디오 제작 짧고 일관된 시퀀스를 위한 시스템.

WAN 2.6 AI 비디오 사용 사례

다시 말하지만, 이러한 사용 사례는 추측에 불과하지만 WAN의 현재 방향과 방향에서 비롯되는 것은 당연합니다. 완 2.5 릴리스는 이미 가능했습니다.

1.네이티브 오디오가 포함된 짧은 소셜 퍼스트 비디오

더 긴 클립과 더 나은 오디오-비주얼 싱크를 통해 완 2.6 다음과 같은 경우에 이상적일 수 있습니다.

- TikTok/Reels/대사 또는 보이스오버가 있는 단편 콘텐츠

- 사운드 디자인이 통합된 제품 티저

- 음성 트랙으로 구동되는 반응 또는 해설 스타일 클립

제작자는 장면과 톤을 설명하고 짧은 오디오 샘플을 첨부하여 다음을 수행할 수 있습니다. WAN 2.6 AI 비디오 제너레이터 비주얼과 사운드를 한 번에 처리할 수 있습니다.

2.음성 기반 퍼포먼스 및 토킹헤드 콘텐츠

WAN 2.6은 다음 메이저가 될 것으로 예상됩니다 AI 비디오 모델 WAN 2.5의 1080p를 기반으로 구축한 알리바바에서 제작, 오디오 싱크 텍스트-투-비디오 AI 더 스마트한 스토리텔링, 더 긴 클립, 더 안정적인 이미지-비디오 생성을 제공합니다.WAN 2.6의 예상 기능, 사용 사례, 제작자가 앞으로 출시될 WAN 2.6에서 기대할 수 있는 사항을 살펴보세요. AI 비디오 생성기.2.5는 이미 “Voice‑to Video”를 지원합니다. 단일 이미지와 오디오로 상세한 얼굴 및 신체 움직임이 포함된 공연 비디오를 제작할 수 있습니다.

완 2.6 이를 다음과 같이 확장할 가능성이 높습니다.

- 토킹헤드 해설자 및 교육용 클립

- 가상 호스트 또는 발표자 비디오

- 녹음된 대화에 동기화된 캐릭터 퍼포먼스 (카툰 또는 리얼리즘)

이를 통해 교육자, 인플루언서 및 브랜드는 실제 촬영을 설정하지 않고도 온카메라 스타일의 콘텐츠를 빠르게 제작할 수 있습니다.

3.컨셉, 제품, 씬 애니메이션

더 안정적입니다 이미지-투-비디오 그리고 더 오래 사용할 경우 WAN 2.6은 아마도 다음과 같은 경우에 강력할 것입니다.

- 제품 이미지를 간단한 데모 비디오로 전환

- 카메라 모션으로 배경 또는 주요 아트 컨셉에 생동감 불어넣기

- 랜딩 페이지, 광고 크리에이티브, 캠페인을 위한 짧은 “히어로 샷” 만들기

이들 AI 비디오 제작 워크플로는 간단한 시나리오를 위해 클래식 3D 또는 실사 촬영을 대체하거나 보강하는 데 도움이 됩니다.

4.프리뷰 및 스토리 탐색

WAN 2.6이 카메라 제어 및 내러티브 일관성을 지속적으로 개선한다면 다음과 같은 경우에 유용할 수 있습니다.

- 스크립트 아이디어 또는 스토리보드 시각화

- 전체 제작 전 다양한 시각적 방향 테스트

- 광고 시퀀스 또는 짧은 내러티브 아크를 빠르게 프로토타이핑할 수 있습니다.

크리에이터와 팀을 위한 이번 시즌 WAN 2.6 비디오 모델 마찰이 적은 샌드박스에 넣어서 페이싱, 프레이밍, 무드를 실험해 보세요.

결론

동안 완 2.6 아직 공식적으로 출시되지 않았지만, 현재 12월에 출시될 것으로 예상되며, 이는 Alibaba가 더 강력하고 멀티모달 모드를 향한 노력을 이어갈 것으로 예상됩니다. AI 비디오 생성 그리고 더 스마트한 스토리텔링.크리에이터에게 이는 더 길고 일관성 있는 클립, 더 나은 시청각 동기화, 더 나은 기능을 의미할 수 있습니다. AI 비디오 모델 실제 생산 워크플로우에 적합합니다.

Akool은 WAN 2.6이 출시되는 즉시 AI 비디오 제품군에 통합할 예정이므로 새로운 WAN 2.6 AI 비디오 기능을 가장 먼저 시험해 볼 수 있습니다.

계속 지켜봐 주세요. Akool의 WAN 2.6으로 차세대 스마트 시네마틱 콘텐츠를 만들 수 있기를 기대합니다.