Einführung in WAN 2.6 (Vorschau)

Alibabas WAN Modelle gehören schnell zu den meistdiskutierten KI-Videogeneratoren. WAN 2.1 erregte Aufmerksamkeit für realistische Grafiken und eine starke Benchmark-Leistung, während WAN 2,5 hat einen großen Sprung eingeführt: 10-Sekunden-Videos mit 1080p und 24 Bildern pro Sekunde mit native audiovisuelle Synchronisation, angetrieben von einer neuen multimodalen Engine, die Text, Bilder, Video und Audio als Eingaben akzeptiert.

Zum Zeitpunkt des Schreibens WAN 2,6 wurde noch nicht offiziell von Alibaba veröffentlicht. Auf der Grundlage der klaren Richtung, die in der WAN 2,5 Ankündigung — längere Clips, synchronisierter Ton und stärkere Kamerasteuerung — es ist vernünftig zu erwarten, dass WAN 2.6 noch weiter voranschreitet filmische KI-Videoerstellung.

In dieser Vorschau schauen wir uns an, was YouTuber erwarten können. WAN 2.6 KI-Video: wahrscheinlich wichtige Funktionen, wie es alltägliche Arbeitsabläufe verbessern könnte und welche Anwendungsfälle diese nächste Generation bietet KI für Text und Bild-zu-Video könnte glänzen.

Was Entwickler von WAN 2.6 erwarten können (prognostiziert)

Hinweis: Die folgenden Funktionen sind spekulativ und basieren auf den offiziellen Funktionen von WAN 2.5 und typischen Upgrade-Mustern in modernen KI-Videomodellen.

1. Längere, kohärentere KI-Videoclips

WAN 2.5 hat die Videolänge bereits von 5 Sekunden auf 10 Sekunden verdoppelt, wobei die Qualität von 1080p und 24 Bildern pro Sekunde beibehalten wurde.

Es ist vernünftig zu erwarten WAN 2,6 um diesen Trend fortzusetzen durch:

- Verlängerung der maximalen Cliplänge über das heutige 10-Sekunden-Limit hinaus

- Verbesserung der narrativen Kohärenz in der gesamten Sequenz

- Reduzierung zeitlicher Artefakte wie Flimmern oder Bildausfälle bei längeren Aufnahmen

Für YouTuber würde das mehr Platz für Multibeat-Aktionen, Mini-Narrative oder Produktsequenzen innerhalb einer einzigen Einheit bedeuten. KI-Videomodell Lauf.

2. Intelligenteres Verständnis von Text zu Video

WAN 2.5 unterstützt bereits „visuelle Steuerung auf Filmebene“ und professionelle Kamerasprache — Beleuchtung, Farbe, Komposition und Aufnahmetyp — direkt von Eingabeaufforderungen aus.

WAN 2.6 Text-zu-Video wird das wahrscheinlich vertiefen:

- Besseres Verständnis komplexer Aufforderungen mit mehreren Klauseln

- Präzisere Ausführung bestimmter Kamerabewegungen (Tracking-Aufnahmen, Zooms, POV)

- Stärkere Abstimmung zwischen emotionalem Ton in der Aufforderung und der resultierenden Szene

Das würde WAN 2.6 KI-Video besser geeignet für strukturiertes Geschichtenerzählen und skriptgetriebene Inhalte, nicht nur für kurze visuelle Experimente.

3. Stärkere Identität und Bewegung von Bild zu Video

Der offizielle WAN 2,5 Hinweise unterstreichen eine stabilere Dynamik und eine bessere Beibehaltung vorhandener Merkmale — Stil, Gesichter, Produkte und Text — bei der Konvertierung von Bildern in Videos.

Darauf aufbauend WAN 2.6 Bild-zu-Video wird wahrscheinlich:

- Halte die Charakteridentität auch bei dramatischeren Bewegungen konsistent

- Behandeln Sie komplexe Bewegungen (Kurven, Sprünge, schnelle Kamerabewegungen) mit weniger Verzerrungen

- Pflegen Sie Logos, UI-Elemente und feine Details während der Animation zuverlässiger

Dies wäre besonders nützlich, um Produkt-Renderings, Charakterkonzepte oder UI-Mockups in flüssige animierte Sequenzen mit minimalem Aufräumen umzuwandeln.

4. Ausdrucksstärkeres Audio und sprachgesteuertes Video

WAN 2.5 ist das erste Angebot der Serie audiovisuelle synchronisierte Videogenerierungund produziert menschliche Stimmen, Soundeffekte und Hintergrundmusik, die zu Bildschirminhalten und Lippenbewegungen passen.

WAN 2,6 wird daher wahrscheinlich:

- Verfeinere die Lippensynchronisation für natürlichere Sprache und emotionale Nuancen

Fügen Sie reichhaltigere Umgebungsgeräusche und abwechslungsreichere SFX-Bibliotheken hinzu - Verbessern Sie „audiogesteuerte“ Workflows, bei denen eine Sprachspur sowohl Bewegung als auch Ausdruck im Video steuern kann

Für Kreative, die sich darauf verlassen KI-Video mit Audio, das könnte bedeuten, dass Clips direkt vom Modell näher am Ende sind, sodass weniger separate Voiceover- oder Musikproduktionen erforderlich sind.

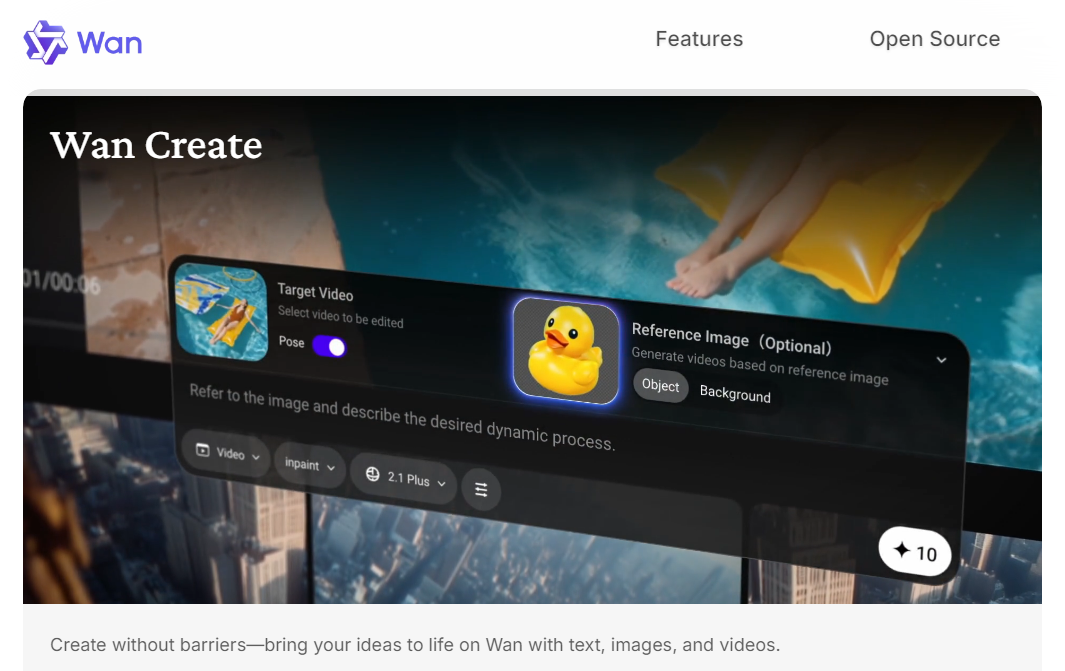

5. Strengere multimodale Steuerungs- und Bearbeitungsabläufe

Die native multimodale Architektur von WAN 2.5 unterstützt bereits Text, Bild, Video und Audio sowohl als Ein- als auch als Ausgänge.

Der nächste Schritt für WAN 2,6 könnte beinhalten:

- Flexiblere Kombinationen von Text, Bild und Audioanweisungen

- Grundlegende Funktionen zum Bearbeiten von Stilen, z. B. das Erweitern einer vorhandenen Aufnahme, Hinzufügen einer neuen Bewegung oder das Anpassen des Stils anhand einer Referenz

- Einfachere Wiederverwendung von Charakteren oder Objekten in mehreren Einstellungen für einfache Sequenzen mit mehreren Aufnahmen

Wenn diese Prognosen zutreffen, könnte sich WAN 2.6 weniger wie ein „Single-Shot-Generator“ anfühlen, sondern eher wie ein kompakter Erstellung von KI-Videos System für kurze, kohärente Sequenzen.

Anwendungsfälle für WAN 2.6 AI Video

Auch diese Anwendungsfälle sind spekulativ, aber sie ergeben sich ganz natürlich aus der aktuellen Ausrichtung des WAN und aus dem, was WAN 2,5 Die Veröffentlichung hat es bereits ermöglicht.

1. Kurzes Social‑First-Video mit nativem Audio

Mit längeren Clips und besserer audiovisueller Synchronisation WAN 2,6 wird wahrscheinlich ideal sein für:

- TikTok//Reels//Kurzfilme mit Dialog oder Voiceover

- Produktteaser mit integriertem Sounddesign

- Clips im Reaktions- oder Kommentarstil, die von einer Sprachspur gesteuert werden

Die Schöpfer könnten die Szene und den Ton beschreiben, eine kurze Hörprobe beifügen und lassen WAN 2.6 KI-Videogenerator Bearbeiten Sie sowohl Bild als auch Ton in einem Durchgang.

2. Sprachgesteuerte Leistung und überzeugende Inhalte

WAN 2.6 wird voraussichtlich der nächste große KI-Videomodell von Alibaba, aufbauend auf 1080p von WAN 2.5, Audio‑synchronisiert KI von Text zu Video um intelligenteres Storytelling, längere Clips und eine stabilere Bild-zu-Video‑Generierung zu ermöglichen. Informieren Sie sich über die voraussichtlichen Funktionen und Anwendungsfälle von WAN 2.6 und erfahren Sie, was YouTuber von der kommenden Version erwarten können KI-Videogenerator.2.5 unterstützt bereits „Voice-to‑Video“, bei dem ein einzelnes Bild plus Audio ein Aufführungsvideo mit detaillierten Gesichts- und Körperbewegungen erzeugen kann.

WAN 2,6 wird dies wahrscheinlich verlängern für:

- Talkende Erläuterungen und Lehrclips

- Videos von virtuellen Moderatoren oder Moderatoren

- Charakterdarbietungen (Zeichentrickfilm oder realistisch) werden mit aufgezeichneten Dialogen synchronisiert

Dies würde Pädagogen, Influencern und Marken eine schnelle Möglichkeit bieten, Inhalte im Stil der Kamera zu produzieren, ohne dass ein physisches Shooting erforderlich wäre.

3. Konzept, Produkt und Szenenanimation

Mit stabilerem Bild-zu-Video und für längere Zeiträume wird WAN 2.6 wahrscheinlich stark sein für:

- Verwandeln Sie Produktbilder in einfache Demovideos

- Erwecken Sie Umgebungen oder wichtige Kunstkonzepte mit Kamerabewegungen zum Leben

- Erstellung kurzer „Hero Shots“ für Landingpages, Werbemittel und Kampagnen

Diese Erstellung von KI-Videos Workflows helfen dabei, klassische 3D- oder Live-Action-Shootings für einfachere Szenarien zu ersetzen oder zu erweitern.

4. Vorschau und Erkundung der Geschichte

Wenn WAN 2.6 die Kamerasteuerung und die narrative Kohärenz weiter verbessert, könnte es nützlich sein für:

- Visualisieren von Drehbutideen oder Storyboards

- Testen verschiedener Blickrichtungen vor der vollständigen Produktion

- Schnelles Prototyping von Anzeigensequenzen für kurze Erzählbögen

Für Entwickler und Teams dreht sich das um WAN 2.6-Videomodell in eine reibungsarme Sandbox, in der du mit Tempo, Rahmen und Stimmung experimentieren kannst.

Fazit

Während WAN 2,6 wurde noch nicht offiziell veröffentlicht. Es wird derzeit erwartet, dass es im Dezember auf den Markt kommt, womit Alibabas Bestreben nach einem leistungsfähigeren, multimodalen System fortgesetzt wird KI-Videogenerierung und intelligenteres Geschichtenerzählen. Für YouTuber bedeutet das wahrscheinlich längere, kohärentere Clips, eine bessere audiovisuelle Synchronisation und eine leistungsfähigere KI-Videomodell für echte Produktionsabläufe.

Akool wird WAN 2.6 in seine KI-Videosuite integrieren, sobald es verfügbar ist, sodass Sie bei der allerersten Gelegenheit mit den neuen WAN 2.6 AI-Videofunktionen experimentieren können.

Bleiben Sie dran und freuen Sie sich darauf, Ihre nächste Welle intelligenter, kinoreifer Inhalte mit WAN 2.6 auf Akool zu erstellen.